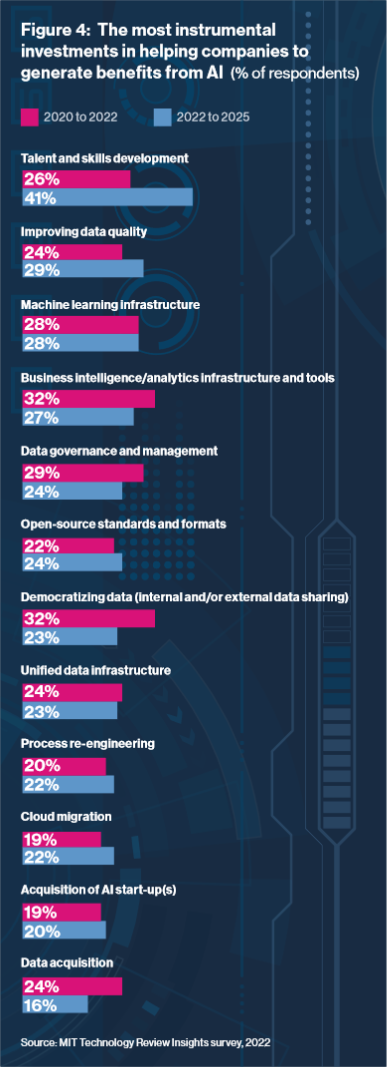

Die Investition in Talente und Mitarbeiterqualifizierung ist unter Berücksichtigung verschiedener Statistiken die Top Investition, um einen nachhaltigen Mehrwert aus Daten und der Technologie KI abzuleiten. Wir haben unsere Experten Prof. Stephan Matzka und Dennis Bogen dazu befragt:

Wie sind Ihre Erfahrungen, wenn Sie mit verschiedenen Unternehmen und Fachbereichen über das Thema Data Literacy & Data Science sprechen?

Prof. Dr. Stephan Matzka: Im Rahmen der digitalen Transformation investieren viele Unternehmen in Cloud-Architekturen und moderne BI-Systeme. Diese fortschrittlichen Technologien und Systeme bringen aber nicht automatisch die gewünschten Effizienz- und Qualitätsverbesserungen mit sich. Es braucht Mitarbeiter:innen, die Daten aufbereiten, analysieren und in Dashboards visualisieren können. Dies ist keine selbstverständliche Fähigkeit, die man als Führungskraft von seinen Mitarbeitern erwarten kann.

Dennis Bogen: Zugleich wächst durch eine fundierte Datenkompetenz das Verständnis über die Notwendigkeit einer hohen Datenqualität für belastbare Vorhersagen und es können schneller Potenziale für Data Analytics Use Cases abgeleitet und evaluiert werden. Erfahrungsgemäß findet bei vielen Unternehmen gerade diese Investition im Bereich „People and Culture“ statt, um eben genau diese erforderlichen Future Skills aufzubauen und die dazugehörigen Rahmenbedingungen für fortschrittliche Analyse zu ermöglichen.

Welchen Unterschied sehen Sie hier zwischen DAX-Konzernen und KMUs?

Dennis Bogen: Sicherlich fällt es einem DAX-Konzern leichter die erforderlichen Investitionen in Cloud- und BI-Umgebungen zu tägigen. Nichtsdestotrotz existiert in größeren Unternehmen eine höhere Vielzahl an Datenquellen (& -silos), die über mehrere Systeme komplex vernetzt sein können. Gleichzeitig sind häufig die dazugehörigen Verantwortlichkeiten stark fragmentiert. Eine sichere Antwort auf die Frage nach der Datenqualität können die wenigstens Unternehmen spontan geben.

Zumal es aus Sicht der Dimension „People & Culture“ bei einem Großkonzern nicht so einfach ist, eine Schulungskampagne für mehrere tausende Mitarbeiter zeitnah freizugeben und diese Qualifizierungsoffensive operativ in kurze Zeit anschließend umzusetzen.

Prof. Dr. Stephan Matzka: Absolut – hier sehe ich ein großes Potenzial bei den KMUs. Die vergleichsweise schlankere Systemlandschaft und Organisationsgröße ermöglicht es schneller einen neuen und datengetriebenen Spirit in die Mannschaft reinzubekommen. Bei einem gut organisierten Rollout kann eine Mitarbeiteranzahl von 50-250 Personen in wenigen Wochen bzw. Monaten gezielt einen fachlichen und methodischen Impuls zu den neuen Möglichkeiten und Grenzen im Bereich Data Analytics erhalten. Ein breites Verständnis über das Thema Data Literacy und Data Science ist ein wesentlicher Enabler bzw. Katalysator für die strategische Agenda einer digitalen Transformation, denn der Grundsatz „culture eats strategy for breakfast“ sollte stets bedacht werden.

Sie wollen mehr zum Thema Datenanalyse erfahren?

Dann besuchen Sie unser Live-Online-Training „Datenanalyse Basiswissen: Daten als Entscheidungsgrundlage aufbereiten, visualisieren und kommunizieren – ohne Programmieren“ mit den Experten Prof. Stephan Matzka und Dennis Bogen.